一、模型部署

本节我们主要讲解在windows11中如何通过ollama部署DeepSeek到本地环境。

1、Ollama安装

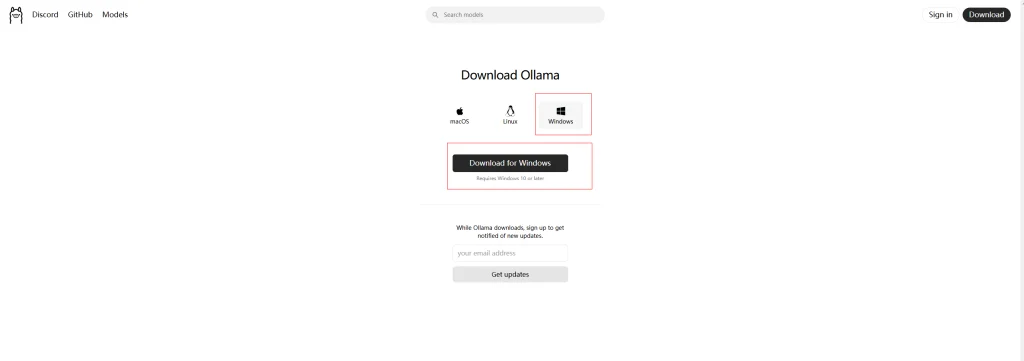

首先登陆Ollama官网下载安装Ollama:https://ollama.com/download/windows

下载完成后运行安装程序进行安装。Ollama的安装非常简单,只需要一直点下一步就行。

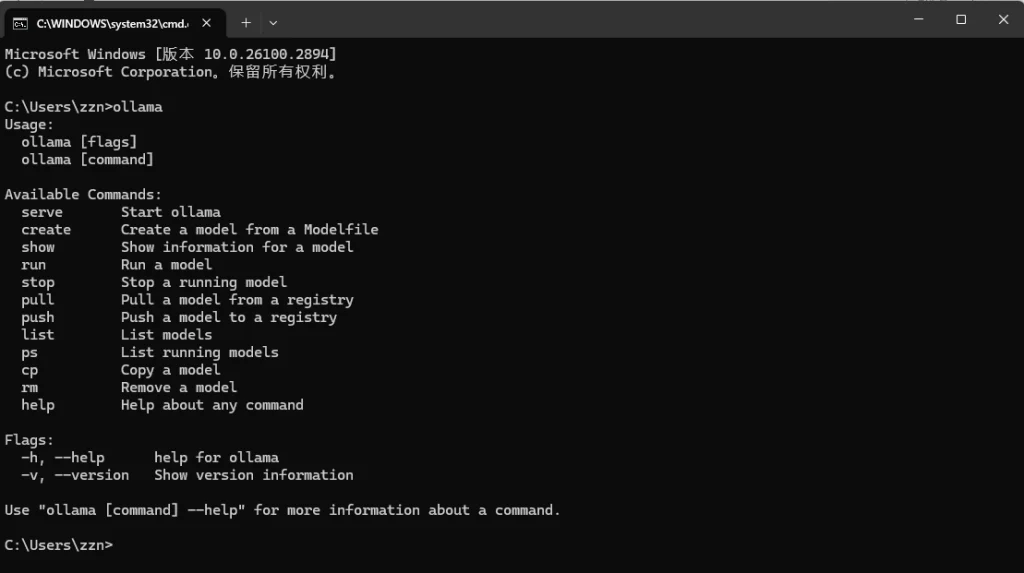

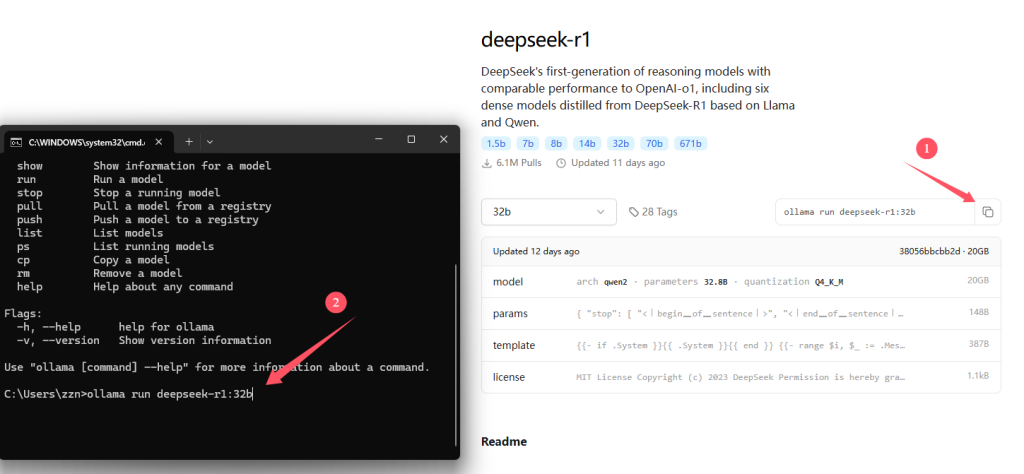

安装成功后,win+R运行cmd输入ollama,如果出现下图显示,则表示安装成功:

2、模型部署

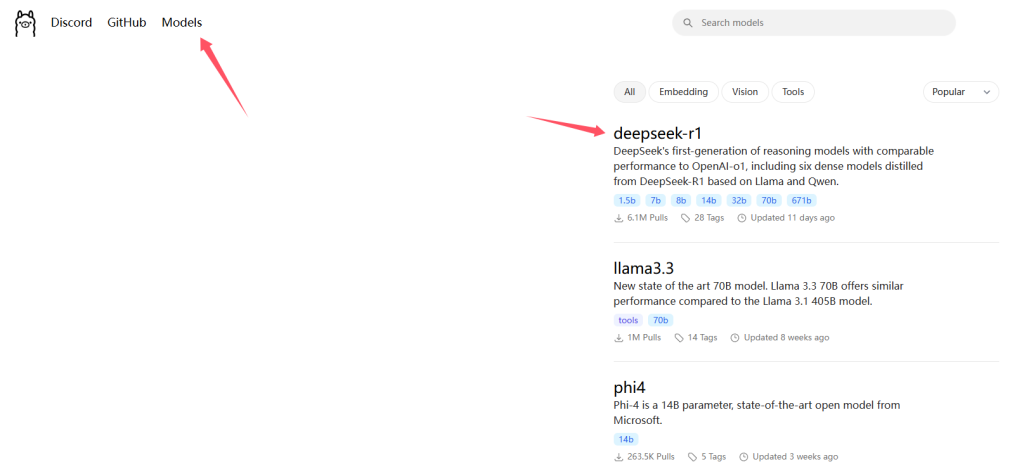

在Ollama官网搜索deepseek-r1,第一个就是。

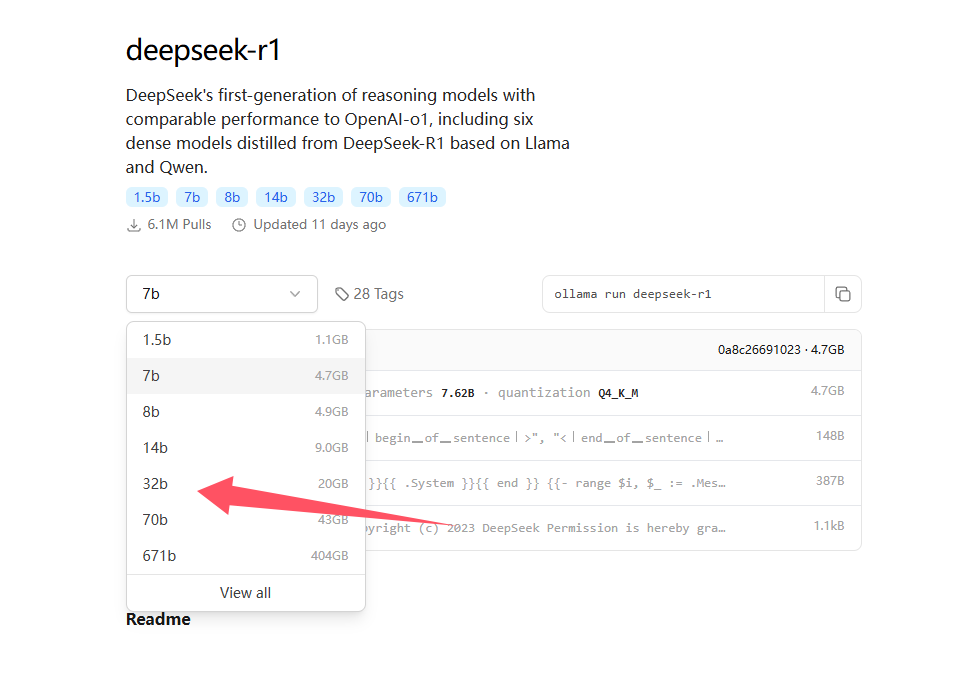

根据自己的显存大小选择对应的版本。我的电脑参数为RTX4070super(12GB显存) + 32GB内存,可以跑32B的,所以这里我选择32B参数大小的。实验证明,70B参数的R1 在24GB显存的RTX4090上可以勉强运行,共占用40GB左右的显存(显存不够了会从内存拿)。

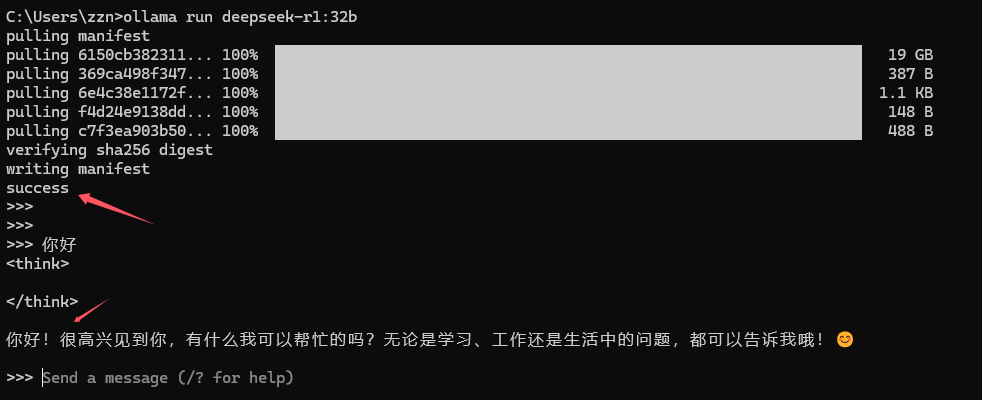

随后在cmd中输入右侧的下载运行代码,ollama会自动下载所需的对应模型文件。

下载完成后,输入启动命令就可以直接与DeepSeek进行对话了。

二、在Anything LLM中配置DeepSeek

1、什么是AnythingLLM?

Anything LLM 是一款专注于本地化部署和私有化管理的大语言模型(LLM)应用平台,旨在帮助用户在企业或个人环境中安全、灵活地构建和运行基于LLM的智能应用。

核心功能

- 本地化部署

- 支持完全离线运行,数据无需上传至云端,保障隐私与安全,尤其适合企业敏感数据或合规需求。

- 可在个人电脑、服务器或私有云环境中部署。

- 多模型兼容

- 支持主流开源模型(如Llama 3、Mistral)和商业API(如GPT-4、Claude),用户可自由切换或组合模型。

- 提供统一的交互界面,简化多模型管理。

- 企业级知识库

- 支持上传文档(PDF、TXT等)、网页内容或数据库,构建私有知识库。

- 通过**RAG(检索增强生成)**技术,让LLM基于定制化数据生成精准回答,提升业务场景适用性。

- 可视化界面与协作

- 提供直观的Web界面,支持团队协作、对话历史管理及权限控制。

- 无需编程即可完成知识库构建、模型配置和对话流程设计。

2、在Anything LLM中配置Deepseek-R1模型(API)

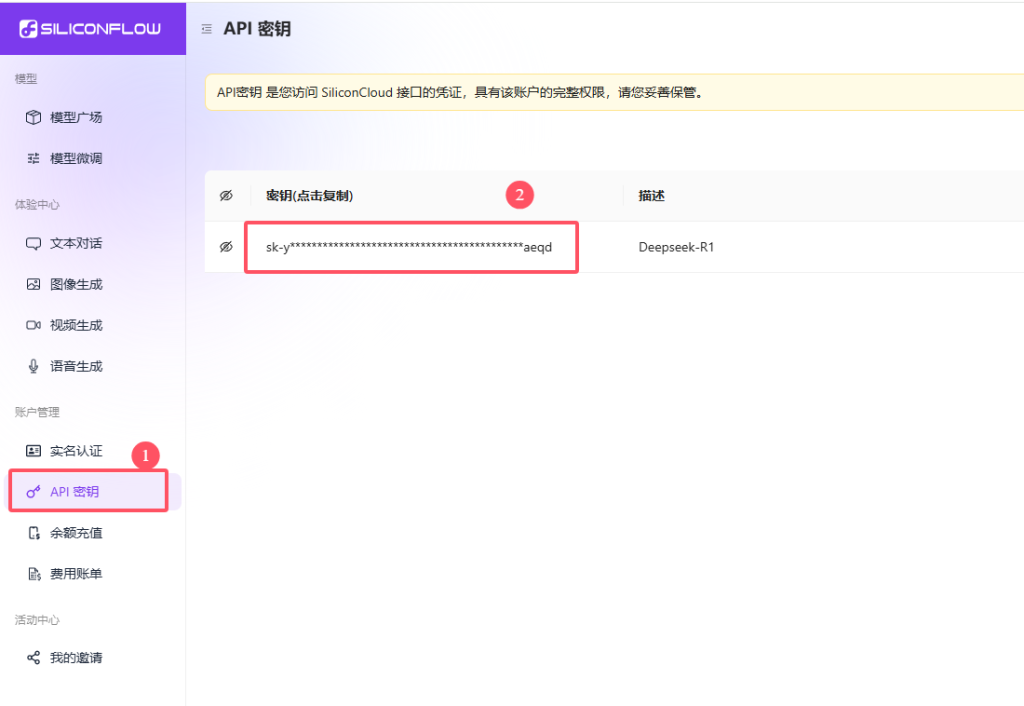

首先在Silicon中注册账号获取API密钥: 点此进入Silicon官方网站

随后点击左侧“API密钥“添加密钥,将其复制下来。

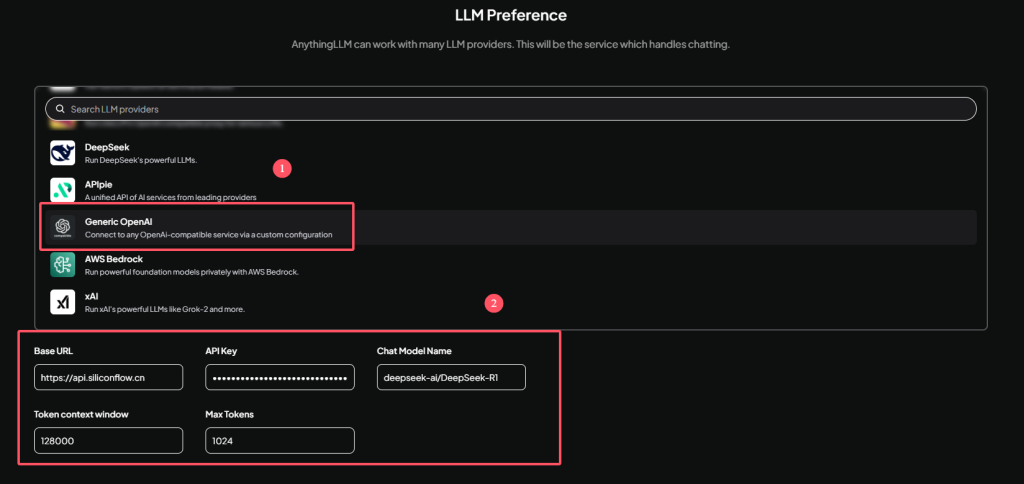

打开Anything LLM软件,在LLM Preference界面找到Generic OpenAI项,下方填入各项参数:

Base URL: https://api.siliconflow.cn

API Key: 你自己的Key

Chat Model Name: deepseek-ai/DeepSeek-R1

接下来一直点击下一步即可。

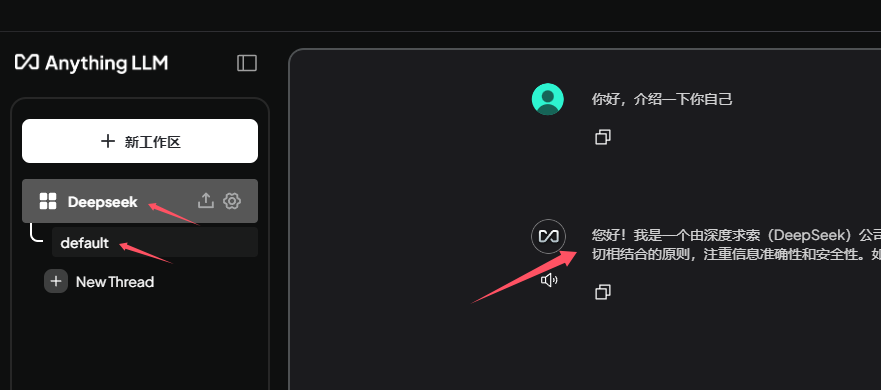

进入主界面后,即可与Deepseek对话(API),注意,在Anything LLM中,是不显示思考过程的,因此可能会感觉有些慢,实际上与官网上的模型速度是一样的。

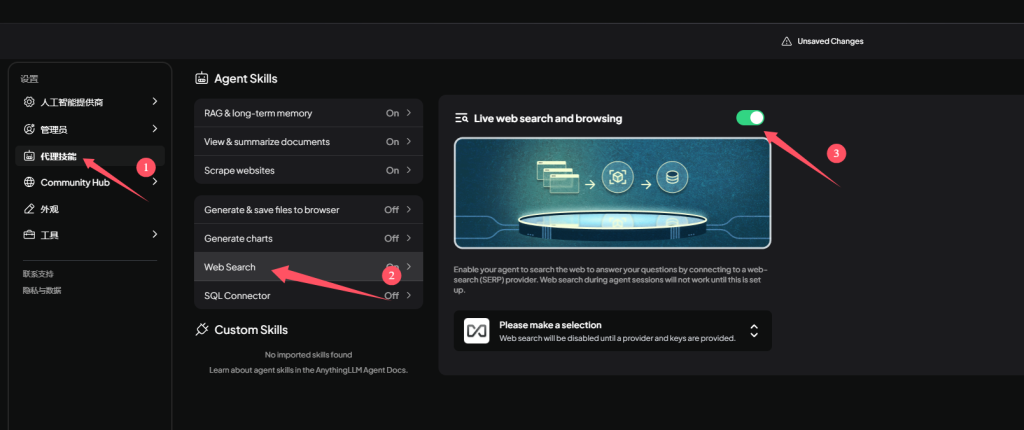

打开联网查找功能

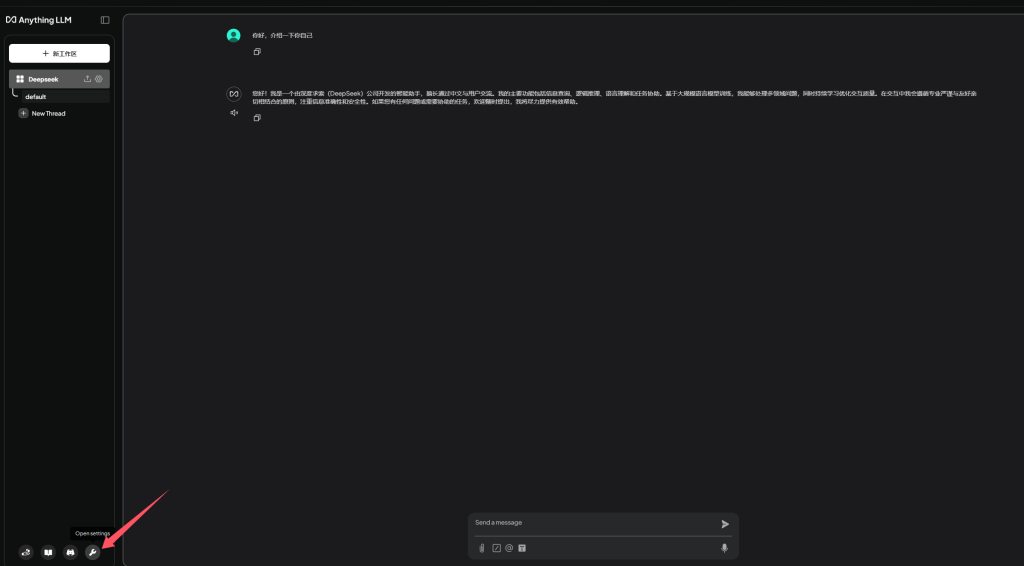

点击左下角的扳手图标进入设置,打开代理技能,选择 Web Search,点击打开即可:

下面的选项选择“Duck Duck Go",点击保存。

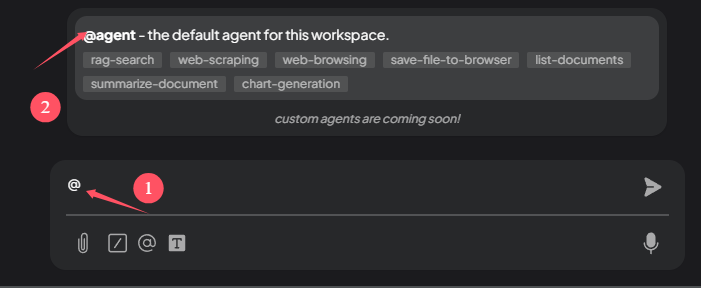

当你想使用搜索功能时,在输入栏中先输入@agent 再输入你想问的问题。

需要注意的是,联网功能原理是agent先去搜索相关条目后给deepseek分析,所以需要使用科学上网,确保能连接上国外网站。

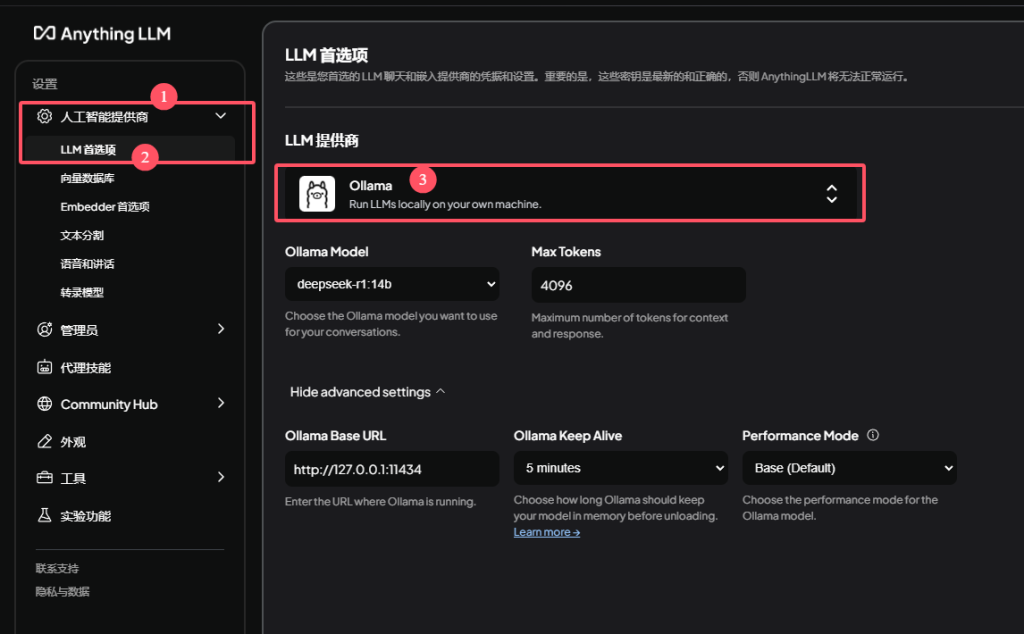

3、在Anything LLM中配置Deepseek-R1模型(通过Ollama本地运行)

点击左下角的扳手图标进入设置,更改人工智能提供商下的LLM首选项,选择Ollama(Ollama要在本地开启运行),点击保存即可。

随后便可开始对话。本地运行的deepseek是可以显示思考过程的。

Comments 1 条评论